360人工智能研究院@AAAI:多模态理解与生成的生态思考与前沿探索

§IAA:赋予语言模型多模态能力的创新架构

·Arxiv: https://www.arxiv.org/abs/2408.12902

·Arxiv: https://www.arxiv.org/abs/2408.12902

·Github: https://github.com/360CVGroup/Inner-Adaptor-Architecture

1. 解决的关键问题

当前多模态大模型在训练中,为提升多模态能力通常需要打开内嵌语言模型参数参与学习,这虽然能够提高模型在多模态任务上的指标,但也产生“副作用”:语言模型原有的文本理解能力因参与多模态训练而发生灾难性遗忘。主流以 LLaVA 系列为代表的桥接式结构多模态模型,在经过多模态数据训练后,内嵌语言模型在文本任务上的能力会产生明显下滑。

2)语言模型的多模态插件生态问题

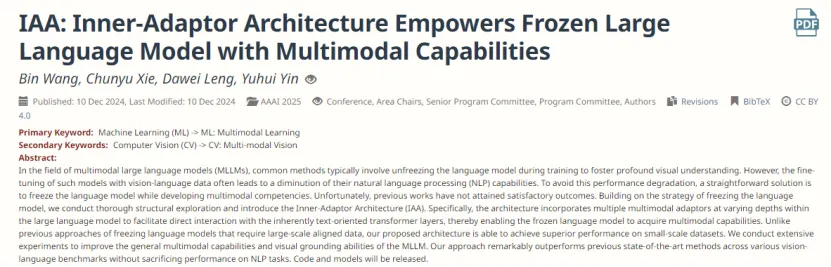

2. 创新的网络结构

1)保持基座语言模型参数不变,避免灾难性遗忘

IAA 在网络设计上保持基座语言模型参数不变,对于多模态知识的学习,则通过多个新增的插入层进行专门处理。新增的插入层在语言模型的不同深度处,与原本以文本为导向的 transformer 层进行交互,使冻结的语言模型能够获取多模态能力。

2)一套模型权重可应对不同任务,降低部署成本

在通用多模态benchmark上,IAA与其它相关工作的指标比较验证了IAA在保持模型原有能力的同时,能有效提升其在多模态任务上的表现。

IAA 网络只需要部署一套模型权重,即可应对不同任务。text-only 任务和多模态任务分别走不同的工作流,避免了翻倍的部署成本。此外,IAA 插件结构不仅适用于多模态任务,对于需要在基座模型能力上特别加强的任务,如 code、math 等任务,一样可以通过插件的方式进行专门增强。

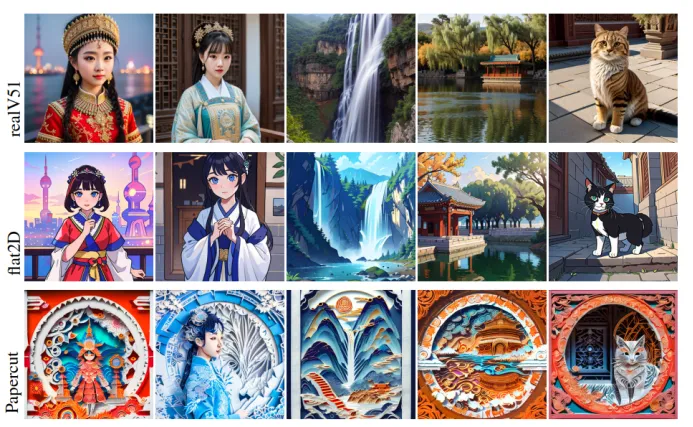

§BDM: 兼容SD生态的中文原生AI绘画

·Arxiv: https://arxiv.org/abs/2309.00952

·Arxiv: https://arxiv.org/abs/2309.009521. 解决的关键问题

1)原生中文及生成模型的世界观偏见

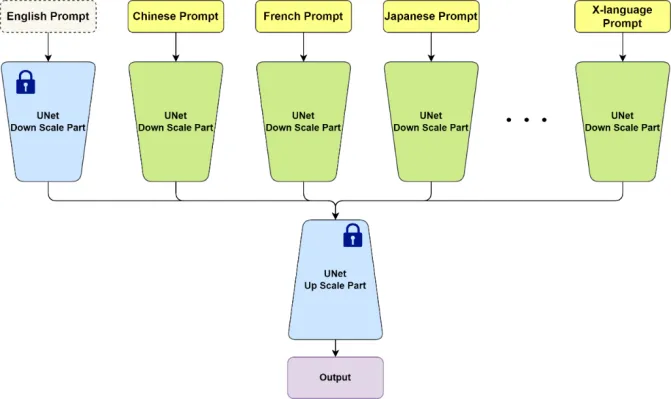

2. 独特的模型结构

1)x-language分支网络,学习不同语言数据

2)生成图像符合中文文化认知,兼容开源社区生态。

结语

-

本文分类: 行业资讯

-

浏览次数: 1969 次浏览

-

发布日期: 2025-01-03 11:19:56

京公网安备 11000002002063号

京公网安备 11000002002063号  电话咨询

电话咨询